À procura de textos e pretextos, e dos seus contextos.

09/06/2009

Equação

O PS e José Sócrates tinham um problema: como manter a maioria absoluta nas legislativas. Agora o problema tem outra equação: como vencer as legislativas.

A vitória do PSD sobre o PS nas europeias não foi a "banhada" do PS sobre o PSD em idênticas eleições em 2004 - "banhada" foi a expressão usada por Marcelo Rebelo de Sousa na época. Nessa altura, o PSD estava no governo comandado por Durão Barroso e coligado com o CDS. O PS, na oposição, era liderado por Ferro Rodrigues.

A "banhada" foi esmagadora e prefigurou o que iria passar-se em 2005, nas legislativas. Só que, no ínterim entre as europeias e as legislativas, passaram-se muitos episódios: o primeiro-ministro fugiu, o governo passou por uma fase carnavalesca, o PS foi levado a mudar de líder.

Nas europeias de domingo os resultados mostraram, não apenas que a maioria absoluta do PS mas até mesmo que a vitória eleitoral, é volátil. Ao mesmo tempo, o PSD apresentou-se como que regenerado e capaz de uma façanha que há bem pouco ninguém admitiria: vencer eleições a curto prazo. E domingo, enquanto o salão de festas do PS desmontava o palanque, a sala do PSD registava enchente, com a ressurreição de imensos desaparecidos em combates passados. E agora, o PS vai ter que reagrupar as hostes, enquanto o PSD vai haver-se com os descrentes reconvertidos pela varinha de condão de uma vitória eleitoral, mesmo que escassa. O PSD ganhou com uma percentagem própria de uma derrota. Os tempos que se seguem vão ser animados.

Nas europeias, o partido do Governo perdeu para todos os quadrantes. Pelo que também não é difícil prever que os meses que aí vêm vão ser de ampla distribuição de rebuçados e outras guloseimas. A questão é que a mercearia já não vende fiado.

D.E. - 09.06. 09

SJ apoia luta dos jornalistas ao serviço do "Público"

O SJ lembra ainda que a empresa editora do “Público” se integra num "sólido e vasto grupo económico-financeiro – a Sonae –, pelo que é justo reclamar que este encontre as vias adequadas para o manter sem sacrificar a parte mais fraca".

É o seguinte o texto, na íntegra, do comunicado do SJ:

SJ solidário com jornalistas do “Público”

1. O Sindicato dos Jornalistas (SJ) saúda a posição dos jornalistas e outros trabalhadores ao serviço do jornal “Público” que rejeitaram a proposta, entregue pela Administração à Comissão de Trabalhadores, de redução salarial escalonada entre os 3 e os 12% nas retribuições brutas superiores a 900 euros, e exigiram mais informação sobre a situação da empresa e os planos de resolução dos seus problemas.

2. O SJ, que tem acompanhado as organizações representativas dos jornalistas e restantes trabalhadores (delegados e CT), reconhece que o sector e a empresa editora do “Público” são afectados pela crise económica que atinge o país, mas considera que lhes foi proposto um esforço excessivo, desproporcionado e sem fundamentação objectiva e transparente.

3. Antes de mais, é necessário recordar que a empresa editora do “Público” se integra num sólido e vasto grupo económico-financeiro – a Sonae –, pelo que é justo reclamar que este encontre as vias adequadas para o manter sem sacrificar a parte mais fraca.

4. Os jornalistas e outros trabalhadores do “Público” têm contribuído para construir e manter de pé um projecto editorial que merece o respeito de todos e que já custou demasiados sacrifícios ao longo dos últimos anos, inclusivamente o desemprego de dezenas de profissionais e a diminuição de direitos essenciais dos que a ele permaneceram ligados.

5. Por outro lado, para pedir sacrifícios aos trabalhadores não basta à empresa invocar tão só a sua necessidade, mas impõe-se que ela os fundamente com dados objectivos e demonstre os efeitos esperados em termos da sua gestão e do seu futuro, circunstância que até agora não se verificou.

6. Solidário com os jornalistas e outros trabalhadores do “Público”, o SJ vai continuar a acompanhar e este processo.

Lisboa, 9 de Junho de 2009 (jornalistas.online)

30º ANIVERSÁRIO DO SERVIÇO NACIONAL DE SAÚDE

SESSÃO/DEBATE

“Revitalizar e Investir no SNS para todos os Cidadãos”

19 de Junho – 14H00

Aula Magna da Faculdade de Medicina de Lisboa (Edifício comum ao Hospital de Sta. Maria – Av. Professor Egas Moniz – Lisboa)

Intervenções: Dr. António Arnaut | Prof. Carlos Silva Santos | Prof. Paulo Kuteev Moreira

BREVES NOTAS DE BALANÇO SOBRE ELEIÇÕES PARA O PARLAMENTO EUROPEU

Audio da Conferência de Imprensa

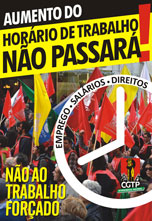

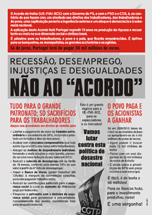

Audio da Conferência de Imprensa A Comissão Executiva da CGTP-IN fez, na sua reunião do dia 8 de Junho, a seguinte apreciação sobre as Eleições para o Parlamento Europeu.

1 – A elevada taxa de abstenção e as suas causas

Um dos aspectos que importa registar neste balanço do processo eleitoral de 07 de Junho, para o Parlamento Europeu, é a significativa taxa de abstenção verificada um pouco por toda a Europa e, em particular, em Portugal. Relevamos cinco causas explicativas no plano geral, a que se acrescenta uma específica da realidade nacional:

i) O afastamento, imposto pelo poder político dominante, dos trabalhadores e dos povos de uma efectiva participação no debate relativo aos assuntos mais relevantes e na definição do rumo do processo de construção europeia, de que é exemplo paradigmático a recusa de um referendo sobre o Tratado de Lisboa;

ii) A constatação que os cidadãos europeus vão fazendo, diariamente, quanto aos impactos negativos das politicas seguidas sobre as suas condições de vida, designadamente, o aumento da insegurança no emprego, da precariedade e do desemprego, a redução dos salários reais e das pensões, o alastramento da pobreza e da exclusão social;

iii) A persistência com que os governantes afirmam as suas políticas como inevitáveis e caluniam todos os protestos dos trabalhadores e dos povos procurando eliminar o surgimento de caminhos alternativos;

iv) O sentimento, que se vai generalizando nas pessoas, de que o poder do voto não é usado pelo poder político para submeter os interesses gananciosos dos detentores do poder económico e financeiro, aos interesses dos povos e dos seus processos de desenvolvimento;

v) A dureza e injustiça da situação em que se encontram as gerações jovens, a quem os governantes e o patronato apenas oferecem desemprego, precariedade no trabalho e incertezas na vida, baixíssimos salários e ameaças constantes de que terão menores direitos sociais que os seus pais e avós;

vi) Em Portugal, acresce a observação de que os problemas se agravam, o nível de vida dos portugueses se distancia (há muitos anos) da média comunitária, a democracia se vem degradando, as desigualdades são mais profundas, ao mesmo tempo que o país está com uma economia e um aparelho produtivo mais frágeis e vulneráveis e com uma dívida externa a crescer perigosamente.

2 – Observações sobre os resultados das eleições

Sobre a análise aos resultados das eleições, a CECO considera que, tendo em conta o papel do movimento sindical na sociedade e as posições político-sindicais da CGTP-IN, se devem relevar os seguintes aspectos:

i) As intensas e abnegadas lutas dos trabalhadores – desenvolvidas desde o local de trabalho à dimensão nacional e nos mais diversos sectores de actividade e regiões, contra políticas erradas e injustas e práticas patronais violadoras dos direitos mais elementares dos trabalhadores, contra a indiferença e a prepotência do Governo face às propostas dos trabalhadores – reclamando mudança de rumo, contribuíram de forma decisiva para que saísse destas eleições uma forte exigência de mudança;

ii) O movimento sindical contribuiu, coma sua acção e proposta, não só para que a força do protesto se tornasse expressiva nas urnas, mas também para que neste acto eleitoral se reforçassem a esperança e a confiança em se encontrarem caminhos alternativos, protagonizados por forças políticas efectivamente de esquerda;

iii) Os resultados das eleições configuram, inquestionavelmente um novo cenário político, que entretanto é preciso consolidar e aprofundar. Há agora uma oportunidade concreta para se encontrarem caminhos políticos que garantam resposta à crise em que o país vive. É tempo de exigir viragem, com uma política que corresponda às necessidades e aos justos anseios dos trabalhadores e do povo português.

3 – É necessário dar o sentido certo à mudança

i) Uma análise objectiva dos problemas com que o país se debate e uma leitura exigente e progressista dos resultados das eleições impõem que o Governo mude de rumo no fundamental das suas políticas, cessando os favores aos grandes capitalistas e às forças sociais e políticas mais conservadoras. Exige-se resposta às reivindicações e propostas dos trabalhadores e das populações mais carenciadas, bem como apoio sério e transparente (com responsabilização dos empresários) ao desenvolvimento da economia portuguesa, com atenção especial ao papel dos micro, pequenos e médios empresários portugueses;

ii) Os resultados eleitorais afirmam a condenação das políticas de direita que há muito vêm a ser prosseguidas. Nos próximos meses, há que travar um forte combate social e político para dar um sentido certo à necessária mudança de rumo. As forças de direita jamais serão protagonistas da construção de um futuro de progresso em que o desenvolvimento humano, a justiça e a igualdade se sobreponham à acumulação da riqueza a favor de alguns;

iii) É preciso agir, mobilizar os trabalhadores, a juventude e as populações em geral para que a situação não se agrave ainda mais. As políticas que estão em curso na União Europeia e em Portugal se não forem travadas e invertidas provocarão, inevitavelmente, mais desemprego, mais precariedade, redução crescente da retribuição do trabalho e um acentuado défice público, que depois os trabalhadores e o povo terão de pagar com enormes sacrifícios;

iv) Neste contexto, ao mesmo tempo que prosseguirá a luta e a mobilização dos trabalhadores por políticas diferentes, mais justas e solidárias, a CGTP-IN apresentará, brevemente, um conjunto de propostas muito concretas a apresentar aos partidos políticos, visando compromissos claros da parte destes, para que das eleições legislativas e autárquicas saiam programas de governação a favor dos trabalhadores, dos cidadãos e do desenvolvimento do país.

CGTP-IN - 09.06.2009

AFP multimédia : quels droits pour les salariés ? (Sud-AFP)

Publié le 9 juin 2009 - Acrimed

Nous publions ci-dessous, et sous son titre original, un communiqué de Sud-AFP (Acrimed).

Les services internet de l’Agence France-Presse sont actuellement assurés par 57 journalistes travaillant dans six langues et repartis sur dix pays, selon un récent document de la direction.

Cette liste montre que la mise en place du multimédia est déjà bien avancée, surtout si l’on ajoute à ces dix rédactions multimédias toutes les unités chargées de confectionner photos, vidéos, infographies, banques de données sportives, etc. Elle montre que le statut de 1957 (le « statut du statu quo », selon l’expression du PDG Pierre Louette, désormais missionné pour le casser) n’a nullement empêché l’AFP d’entamer sa modernisation en négociant le tournant du multimédia.

L’analyse de cette liste nous amène cependant à un autre constat : sur les 57 journalistes assurant ce que le Plan Louette présente comme le cœur du métier de demain, seuls 15 (soit 26%) sont considérés comme des salariés de l’AFP à part entière, avec contrat régi par le Code du travail français (statut siège), leur permettant de bénéficier des accords collectifs et de participer à l’élection des membres du comité d’entreprise et des délégués du personnel pour les représenter vis-à-vis de l’employeur à Paris.

Autrement dit, la grande majorité – 74% – des journalistes multimédias de l’AFP ne bénéficie pas de ces droits. Vis-à-vis de l’AFP Paris, ils sont des sans-droits. Leur situation est plus ou moins précaire et varie d’un pays à l’autre, allant d’un bon niveau de rémunération et d’une bonne protection sociale pour les salariés de la filiale allemande AFP GmbH (ils sont six, dont cinq en CDI), à un statut de salarié jetable ailleurs. 36 journalistes multimédias sont sous contrat local dans huit pays, avec autant de législations différentes : Brésil, Chypre, Espagne, Etats-Unis, Hong-Kong, Inde, Royaume-Uni, Uruguay.

A cette précarité, due à une différence de statut, s’ajoute celle liée au contrat de travail : sur les 57 journalistes multimédias listés par la direction, onze (soit 19%) ne sont pas inscrits dans l’annuaire de l’intranet car il s’agit de salariés locaux en CDD. Par ailleurs, la liste donne l’impression que tous les salariés de la Rédaction multimédia à Paris sont en CDI car elle fait l’impasse sur les trois à cinq CDD qui y travaillent régulièrement.

Dix rédactions, autant de statuts différents. Et seule une minorité bénéficiant des pleins droits du statut siège.

Agence de demain, méthodes d’hier ?

Aucun argument rédactionnel ne peut justifier cette différence de traitement. Les raisons en sont uniquement économiques et du domaine de la gouvernance de l’entreprise : l’AFP agit comme tout groupe capitaliste multinational, en délocalisant ses activités, à la recherche des moindres coûts et selon le principe du "diviser pour mieux régner".

Au moment où le Plan Louette envisage d’augmenter le chiffre d’affaires en misant sur une forte "croissance externe" (achat de sociétés, créations de nouvelles filiales), la liste des « 10 rédactions multimédias AFP » montre qu’il y a effectivement urgence à moderniser l’AFP... dans un domaine totalement négligé par le Plan Louette, celui des relations sociales.

Pour Sud, tous les personnels qui contribuent de façon régulière aux services de l’AFP doivent pouvoir bénéficier des mêmes droits. Qu’ils travaillent en France ou ailleurs.

Paris, le 8 juin 2009

Maladie mentale et exclusion: Étude des décisions de révision de cure fermée de la Commission des affaires sociales

L'évaluation de l'état mental et l'évaluation de la dangerosité sont les deux critères sur lesquels reposent les décisions de mettre un individu en cure fermée et, lorsque cette décision est contestée, d'en reconduire le cours. L'article 11 de la Loi de la protection du malade mental précise, en effet, que pour qu'un individu soit admis en cure fermée, son état mental doit être susceptible de mettre en danger sa santé ou sa sécurité ou la santé et la sécurité d'autrui. Or, l'évaluation de l'état mental et de la dangerosité nécessite de la part du psychiatre une prédiction pour laquelle il ne dispose d'aucun critère objectif. Dans un tel contexte, la question de l'exclusion demeure des plus pertinentes.

S'inscrivant dans la perspective de la théorie de la désignation, cette thèse tente de répondre à la question suivante: les décisions écrites de révision de cure fermée rendues par la Commission des affaires sociales (CAS) contiennent-elle des traces des mécanismes de l'exclusion?

Deux objectifs ont gouverné la démarche. Le premier, d'ordre descriptif, a consisté à analyser le contenu de ces décisions. Le second, d'ordre analytique, a consisté à vérifier si ces décisions contenaient des traces d'exclusion telle que la conçoit la théorie de la désignation.

Sur le plan méthodologique, l'étude se divise en deux volets. Le premier a pris la forme d'une observation en situation des audiences tenues par la Commission des affaires sociales. Le second, fondé sur l'analyse de contenu thématique, a consisté à faire la description détaillée de 120 décisions rendues par la CAS entre 1990 et 1993. Les décisions analysées étaient équitablement réparties à l'intérieur de deux corpus; un premier regroupant des décisions de levée de la cure, un second des décisions de maintien de la cure.

À l'encontre de la première hypothèse de travail retenue et dans laquelle était postulée qu'il existait entre les corpus des différences logiquement importantes, les résultats de l'étude ont plutôt montré que les décisions, quelqu'en soit l'issue, ne présentaient à peu près aucune différence significativement importante. Par ailleurs, les deux corpus sont traversés par les mécanismes de l'exclusion tels que les conçoit la théorie de la désignation. Ce qui signifie, très concrètement, que l'exclusion ne prend pas fin avec la levée de la cure.

Ces résultats soulèvent de nombreux enjeux éthiques et rendent nécessaire le questionnement sur les effets persistants de la stigmatisation psychiatrique.

Ce qu'Obama n'a pas dit dans son discours du Caire en dit très long sur sa politique au Moyen Orient

Sur ce que projetait de dire Obama dans son discours du 4 juin au Caire, en Egypte, CNN titrait: " Obama cherche à atteindre l'âme du monde musulman".

Peut-être cela résume-t-il bien son propos, mais plus significatif est le contenu qui se cache derrière les tournures rhétoriques, ou plus exactement, ce qui a été omis.

Si on ne s'en tient qu'à ce qu'il a dit au sujet d'Israël et de la Palestine (il n'y avait rien d'essentiel sur tout le reste), Obama a appelé les Arabes et les Israéliens, à ne pas se "montrer du doigt" ou "à ne pas considérer ce conflit sous un seul angle". Il y a pourtant un troisième angle, celui des Etats-Unis, qui ont joué un rôle décisif en soutenant le conflit actuel. Obama n'a donné aucune indication que leur rôle devait changer.

Ceux qui connaissent bien cette histoire en concluront rationnellement alors qu'Obama poursuivra sur la voie du réjectionisme unilatéral US.

Une fois de plus, Obama a fait l'éloge de l'Initiative de Paix arabe, disant seulement que les Arabes devraient la considérer comme "un début significatif, mais pas la fin de leurs responsabilités".

Comment l'administration Obama doit-elle voir cela?

Obama et ses conseillers sont sûrement conscients que cette initiative ne fait que reprendre l'ancien accord international qui appelait à la création de deux états indépendants avec les frontières définies par la communauté internationale (donc d'avant juin 1967), peut-être avec des "modifications mineures et consenties par les deux parties", pour reprendre les termes employés par le gouvernement américain jusqu'à ce qu'il rompe brutalement dans les années 70 avec l'opinion internationale. C'est-à-dire quand les Etats-Unis avaient opposé leur veto à une résolution du Conseil de Sécurité de l'ONU soutenue par les états arabes "de confrontation" (Egypte, Iran, Syrie) et tacitement par l'OLP, avec le même contenu essentiel que l'Initiative de Paix Arabe, sauf que cette dernière va plus loin en appelant les états arabes à normaliser les relations avec Israël dans le contexte de cet accord politique.

Obama a appelé les états arabes à poursuivre la normalisation, en ignorant soigneusement, cependant, les accords politiques cruciaux qui la conditionnent. Cette initiative ne peut pas être un "point de départ" si les Etats-Unis continuent d'en refuser les principes essentiels, voire de les reconnaître.

Derrière tout cela figure l'objectif du gouvernement Obama, énoncé très clairement par le sénateur démocrate du Massachusetts, John Kerry, président du comité des affaires étrangères du sénat, de créer une alliance entre Israël et les états arabes "modérés" contre l'Iran. Le terme de "modéré" n'a rien à voir avec la spécificité de l'état en question, mais indique son empressement à souscrire aux exigences des Etats-Unis.

Qu'est censé donner Israël en contrepartie des mesures prises par les Arabes pour normaliser leurs relations?

La position la plus ferme jusqu'à présent de l'administration Obama, c'est qu'Israël devait se conformer à la Phase I de la Feuille de Route de 2003 , qui stipule: "Le gouvernement d'Israël gèle toute activité de colonisation (même lorsqu'il s'agit de l'expansion naturelle des colonies)".

Toutes les parties affirment accepter cette feuille de Route en fermant toutefois les yeux sur le fait qu'Israël avait immédiatement fait ajouter 14 réserves qui la rendent caduque.

Ce qui a été négligé dans le débat sur les colonies, c'est que même si Israël devait accepter la Phase I de la Feuille de Route, cela laisserait en place l'ensemble du projet de colonisation qui a déjà été développé, grâce au soutien décisif des Etats-Unis, et qui permet de s'assurer qu'Israël récupèrera bien les terrains précieux qui ont été enclavés par le "mur de séparation" illégal (y compris les ressources en eau de la région), ainsi que la vallée du Jourdain, ce qui engloberait tout le reste, fragmenté en cantons constitués de colonies et d'infrastructures qui s'étendent loin vers l'est.

Ce dont il n'a pas été question non plus, c'est qu'Israël est en train de s'approprier le Grand Jérusalem, site de ses principaux projets de développement actuels, en délogeant de nombreux Arabes de façon à ce que ce qui restera aux Palestiniens sera séparé du centre de leur vie culturelle, sociopolitique et économique.

Ce qui n'a pas été dit non plus, c'est que tout cela se fait en violation des conventions internationales, telles qu'elles avaient été acceptées par le gouvernement d'Israël après la conquête de 1967, et réaffirmées par les résolutions du Conseil de Sécurité et de la Cour Internationale de Justice.

N'ont pas été évoquées non plus, les manoeuvres réussies d'Israël depuis 1991 pour séparer la Cisjordanie de Gaza, devenue depuis une prison où la survie est à peine possible, et qui anéantissent davantage les espoirs de créer un état palestinien viable.

Il est bon de se rappeler qu'il y a eu une seule rupture dans le réjectionisme Etats-Unis - Israël.

Le président Clinton avait reconnu que les conditions qu'il avait offertes lors du sommet de Camp David en 2000, et qui s'était soldé par un échec, n'étaient pas acceptables pour un Palestinien et en décembre, il avait proposé ses "paramètres", vagues, mais plus amènes. Il avait ensuite annoncé que les deux parties acceptaient ces paramètres, alors qu'elles avaient toutes deux émis des réserves.

Les négociateurs israéliens et palestiniens s'étaient rencontrés à Taba, en Egypte, pour aplanir les différences, et avaient considérablement progressé. Une résolution décisive pourrait être adoptée dans quelques jours, annonçaient-ils lors d'une conférence de presse commune. Mais Israël avait annulé les négociations prématurément et elles n'avaient jamais été reprises officiellement.

Cette seule exception indique que si un président américain est prêt à accepter des négociations diplomatiques constructives, un accord peut très certainement être conclu.

Il est également bon de se rappeler que l'administration Bush est allée plus loin que les discours dans ses critiques contre les projets de colonies illégales d'Israël, à savoir, en refusant de leur apporter un soutien financier.

En revanche, selon le New York Times (Helene Cooper, 1 juin), les hauts responsables du gouvernement d'Obama ont déclaré que de telles mesures n"'étaient pas à l'ordre du jour" et que les pressions sur Israël pour qu'il se conforme à la Feuille de Route seront "largement symboliques".

Il y a plus à dire, mais cela n'est pas pour améliorer le tableau sinistre qu'Obama a peint, avec quelques touches supplémentaires, dans le discours, annoncé en fanfare, qu'il a adressé au Monde Musulman le 4 juin.

Beaucoup de "maquillage" religieux et pas d'avancées. Et toujours les mêmes discours sur le Hamas, l'Iran, le droit d'Israël de se défendre ... Pas un mot sur les massacres de janvier. Les attentats dont il parle sont ceux commis par les Palestiniens. Etc.

Il est très fort.

Taxa de desemprego sobe para os 7,8 por cento nos países da OCDE

Face a Abril de 2008, a taxa de desemprego no conjunto dos 29 membros da OCDE aumentou em 2,2 pontos percentuais.

Portugal apresenta a quinta maior taxa de desemprego dos países da OCDE, com 9,3 por cento da população activa desempregada, após Espanha (18,1 por cento), a Eslováquia e a Irlanda (ambas com 11,1 por cento) e a Hungria (9,6 por cento).

Na zona euro, a taxa de desemprego era de 9,2 por cento em Abril e de 8,6 por cento na União Europeia, de 8,9 por cento nos Estados Unidos e de cinco por cento no Japão.

Publico.pt - 09.06.09

Taux et niveaux de chômage harmonisés pour les pays de l'OCDE

L'assassinat de George Tiller relance la question de l'activisme anti-avortement aux Etats-Unis

George Tiller, chirurgien dans une clinique du Kansas, a été assassiné dimanche dernier alors qu'il assistait au service religieux de sa paroisse. Ironie du sort?

Tiller, comme tous ceux qui pratiquent l'avortement, subissent les assauts constants des groupes "pro-life".

Le lobby anti-avortement aux Etats-Unis est très actif et, comme le lobby des armes, la NRA, prend aussitôt les armes dès qu'il y a un soupçon d'avancées progressistes dans leurs domaines respectifs.

Des lobbys très engagés dans la campagne contre Obama.

Les activistes pro-life sont prêts à tout et dangereux.

Leur méthode: le harcèlement constant des médecins et du personnel qui travaillent dans les cliniques qui pratiquent l'avortement.

Parallèlement, ils sont assurés du soutien (et de la propagande) d'animateurs télé vedettes comme Bill O'Reilly qui crache sa haine sur Fox News, entre autres, avec des notions simplistes assénées sur des esprits simples, voire dérangés.

C'est effrayant. Et c'est au nom de la liberté d'expression.

Une liberté d'expression qui semble, pour autant, bien plus facilement accordée à l'idéologie de droite radicale, voire d'extrême droite, qu'aux idées progressistes, qui sont, elles, noyées sous un torrent d'insanités de la part des précédents.

Ci-dessous: la traduction d'un article "The Tiller Murder Wasn't a Lone Killer's Sick Plot; It Came Out of the Radical Anti-Abortion Movement" de Jill Filipovic publié le 1 juin 2009 dans Alternet, paru initialement dans le Guardian

L'assassinat de Tiller n'est pas l'acte isolé d'un détraqué, c'est le pur produit du mouvement radical anti-avortement

L'assassinat du docteur George Tiller est la réponse logique aux discours de plus en plus violent d'experts comme Bill O'Reilly ou de groupes radicaux "pro-life". George Tiller, médecin au Kansas, a été tué par balle à l'église dimanche dernier. C'était un des rares médecins aux Etats-Unis à pratiquer des avortements thérapeutiques tardifs (interruption médicale de grossesse – IMG) quand c'était nécessaire – quand il s'agissait de femmes dont la grossesse mettait en danger leur vie ou leur santé, ou lorsque le fœtus comportait des anomalies graves. Les femmes venaient de tout le pays consulter Tiller quand leur propre médecin ou les autorités médicales locales ne pouvaient rien faire. Pour de nombreuses femmes, Tiller était, comme l'a formulé une de ses patientes:"la seule lumière qui ait brillé pendant semaine la plus terrible de mon existence".

Il était aussi un des principaux paratonnerres dans les guerres contre l'avortement.

Les pro-life harcelaient ses patientes, jour après jour. Ils ont fait exploser une bombe dans sa clinique. Ils lui ont tiré dessus une fois déjà. Ils accumulaient les procès et avaient même réussi à convaincre certains procureurs locaux d'ouvrir à des enquêtes criminelles et d'engager des actions en justice (où ils n'ont jamais gagné). Ils publiaient l'adresse de son domicile et les noms complets des membres de sa famille sur leurs sites internet. Il postaient des renseignements sur *tous ceux avec qui il était en contact, depuis l'épicerie où il achetait son café jusqu'à la teinturerie où il déposait ses vêtements.

Ils l'ont contraint, ainsi que son personnel, à porter un gilet pare-balles pour aller travailler. Tiller roulait dans une voiture blindée et protégeait sa maison avec un système de sécurité ultra-performant. Et pour permettre de mieux le traquer et le harceler, ils publiaient ses allées et venues quotidiennes – dont le fait qu'il assistait tous les dimanches au service religieux à l'Eglise Réformée Luthérienne, l'endroit où on lui a tiré dessus et tué.

Et tout cela parce que c'était un spécialiste avec les compétences nécessaires pour pratiquer des actes chirurgicaux légaux.

Ceci ne surprendra personne: son assassin est fortement soupçonné de faire partie du mouvement "pro-life". Si c'est le cas, Tiller serait la dixième personne à avoir été assassinée aux Etats-Unis par les terroristes anti-avortement.

Et là, il ne s'agit que de la partie émergée de l'iceberg.

Tiller lui-même avait réchappé à un assassinat en 1993. Depuis 1977, il y a eu au moins 17 tentatives d'assassinats, 383 menaces de mort, 153 affaires de coups et blessures et trois enlèvements commis contre ceux qui pratiquent des avortements.

Certains groupes anti-avortement publient des déclarations pour condamner ce meurtre et pour le faire passer pour celui d'un extrémiste. Mais ce récent acte de terrorisme n'est, hélas, pas une anomalie. Il fait partie d'un plan de harcèlement, d'intimidation et de violence contre ceux qui pratiquent l'avortement et contre les militants pro-choix. Et les groupes anti-avortement traditionnels en portent largement la responsabilité.

Les organisations pro-life utilisent souvent les termes de "meurtre", génocide" ou "holocauste" pour décrire les avortements.

Ils publient sur leurs sites les noms complets de ceux qui pratiquent les avortements, ainsi que leur adresse, le numéro d'immatriculation de leur véhicule, leur photo, les noms de leurs enfants et des écoles que fréquentent ces derniers (parfois avec des posters ""Wanted" bien pratiques, dans le style des westerns, comportant des promesses de récompenses de 5000 dollars ).

Quand on persuade ses adeptes que ceux qui pratiquent l'avortement sont comparables aux officiers SS qui ont tué des innocents par millions, qu'on leur dit que c'est une guerre "totale" qui est engagée contre les pro-choix et qu'on leur fournit l'adresse personnelle et les renseignements utiles sur ces praticiens "monstrueux", "tueur de bébés" contre lesquels on est censé être en guerre, on ne peut pas faire les étonnés quand ces adeptes en concluent qu'il est moralement justifiable de se servir de ces informations pour tuer des médecins.

Ce ne sont pas des groupes marginaux .

Bill O'Reilly, le célèbre animateur de télé conservateur, a traité la clinique de Tiller de "moulin de la mort", accusé Tiller d'être un "assassin de bébés" qui "exécute des bébés sur le point de naître" et a déclaré que Tiller commettait des actes nazis pour lesquels il avait "du sang sur les mains".

Frank Pavone, prêtre catholique, membre de l'association de James Dobson, "Focus on the Family" et directeur de "Les Prêtres pour la Vie", postait, dimanche dernier, une vidéo sur You Tube pour dire qu'il "hait" la violence qui a été commise sur Tiller mais que "nous n'avons aucun élément et nous ne devons pas tirer des conclusions hâtives" (en décrétant que c'est un terroriste anti-avortement qui a peut-être assassiné Tiller), même s'il reconnaît que quelqu'un l'a peut-être assassiné "afin d'empêcher Tiller de tuer d'autres bébés".

Il poursuit:" Quand on parle d'avortement, on parle de meurtre. Il n'y a pas d'autre mot … c'est un holocauste à grande échelle, c'est assassiner".

Pavone est pote avec Operation Rescue, dont le fondateur, Randall Terry, a déclaré ceci à propos de l'assassinat de Tiller:

George Tiller était un tueur en série. Nous avons du chagrin pour lui qu'il n'ait pas eu le temps de préparer son âme à sa rencontre avec Dieu.

Je suis plus inquiet sur le fait que l'administration d'Obama va utiliser le meurtre de Tiller pour intimider les anti-avortement afin que nous abandonnions nos discours et nos actions les plus efficaces. L'avortement, c'est toujours un meurtre. Et nous devons toujours encore appeler l'avortement par son vrai nom: meurtre.

Ces hommes et ces femmes qui assassinent les fœtus sont des assassins selon la loi de Dieu. Nous devons continuer à les dénoncer dans nos communautés et manifester sans violence contre eux devant leur lieu de travail et leur domicile, et, oui, même devant leurs églises.

Ca c'est de la définition de manifester sans violence!

Le principal suspect du meurtre de Tiller faisait partie des habitués, paraît-il, du site d'Operation Rescue (qui avait une rubrique spéciale "Infos Tiller"), et avait participé à certaines de ces "manifestations non violentes" qui tiennent tant à cœur aux anti-avortement.

Loin d'être un extrémiste isolé, il semble avoir été plutôt impliqué dans le mouvement pro-life.

Et si c'est bien lui qui a assassiné Tiller, il n'est pas le seul parmi les anti-avortement à adhérer à la directive de Terry qui dit que "Si vous pensez que l'avortement est un meurtre, agissez de même". (Terry n'avait-il pas déclaré: "cela n'aurait-il pas été normal de tuer Hitler sachant qu'on pouvait sauver des millions de Juifs?").

Les anti-avortement autoproclamés ont fêté l'assassinat de Tiller en laissant des centaines de commentaires sur les blogs de droite radicale (et bon nombre d'autres sur les blogs de gauche et pro-choix pour faire bonne mesure).

L'écrivain conservateur LaShawn Barber savourait l'ironie qui avait voulu que "Tiller le Tueur de bébés, cultivateur de la mort" soit assassiné pendant un office religieux.

Si on jette un rapide coup d'œil sur le portail de ProLifeBlogs.com, on trouve des titres du genre: "George Tiller a assassiné son dernier bébé", "Tiller le Tueur tué", "Aujourd'hui, Tiller le Tueur, devenu martyr de Moloch, a rencontré Dieu", etc.

Ces gens-là ne sont pas des brebis galeuses. Ils sont symptomatiques (et parfois les porte parole) d'un mouvement global qui est malsain et dangereux.

Alors que des personnes isolées qui se revendiquent pro-life peuvent être de bonne foi et opposées à la violence, les associations anti-avortement et ceux qui les dirigent se fichent bien de la vie, avant ou après la naissance. Et si ces associations condamnent du bout des lèvres l'assassinat de Tiller, elles continuent d'utiliser le même discours délirant et incendiaire qui l'a inspiré et rendu possible.

Les mots ont un sens. Les pro-life doivent sans aucun doute pouvoir exprimer leur opinion, mais ils doivent également réaliser que les actes ont des conséquences et que leur discours n'est pas anodin.

Si vous hurlez "au feu" dans une salle de spectacle bondée, on peut raisonnablement penser que cela va provoquer une panique et que des gens vont être blessés. Et si vous criez "assassin!' Tueur d'enfants" et "holocauste" suffisamment longtemps, on peut raisonnablement penser que quelqu'un va se charger d'appliquer la loi du talion (surtout si vous fournissez le nom et l'adresse de la personne qui, selon vous, commet un "génocide").

Cet acte n'a pas été celui d'un extrémiste isolé. C'est un acte de violence de plus à ajouter à une longue, très longue liste de crimes commis par les terroristes anti-avortement, et l'issue logique à des années de discours et d'actions de plus en plus violents, déshumanisants et menaçants de la part des associations pro-life "classiques".

Certes, la responsabilité de la mort de George Tiller repose sur les épaules de celui qui a appuyé sur la détente. Mais quand les groupes anti-avortement ont tout fait pour, à part lui fournir l'arme, on ne peut pas dire qu'ils aient les mains propres.

Jill Filipovic est avocate à Manhattan et a été rédactrice en chef de la rubrique "Femmes et justice reproductrice" d'AlterNet. On peut lire d'autres articles sur son blog.

Notes

(en anglais)

Source originale (avec commentaires) le Guardian

*tous ceux avec qui il était en contact:

One Man's God Squad

Bill O'Reilly est, entre autres, présentateur sur Fox news.

Autres articles (en anglais) sur O'Reilly:

Slam Bill O'Reilly for His Jihad Against Dr. George Tiller (Haro sur Bill O'Reilly et sa croisade contre le docteur George Tiller)

et:

Is Bill O'Reilly Spawning Killers?

(O'Reilly crée-t-il des assassins?)

Autres liens et commentaire personnel:

Cette question soulève d'une part la violence, l'acharnement et l'activisme aux Etats-Unis des groupes anti-avortement et d'autre part la question de la liberté d'expression.

Dans un pays où les décisions gouvernementales s'appuient sur la bigoterie, particulièrement ces dernières années, et où sont préconisés le créationnisme, l'abstinence, et autres concepts religieux irrationnels, où l'éducation sexuelle n'est pas généralisée dans les écoles, où le planning familial est montré du doigt, mais où la production de porno est la plus florissante, on ne peut pas s'étonner qu'il y ait autant de tordus incultes obsédés de sexe et de domination masculine (blanche).

Pour ce qui concerne l'avortement, si celui-ci est autorisé dans tous les états, l'accès à l'éducation sexuelle, à la contraception, à la "pilule du lendemain" et à l'avortement est très variable et discriminatoire.

En effet, sa pratique dépend de l'état, de la communauté (ethnique et/ou religieuse), de la proximité de centres de planning familial, de cliniques ou de pharmacies, du bon vouloir de médecins et pharmaciens (beaucoup se prévalant de la "clause de conscience" pour refuser contraception ou recours à l'avortement), du niveau socio-culturel de la personne concernée, de son éducation, de ses revenus, et d'autres facteurs encore.

Et la politique rétrograde de Bush et consorts (qui finançaient les organisations prônant l'abstinence aux dépens des plannings) n'a pas amélioré la situation, qui n'était pourtant pas bien encourageante.

Il faut savoir également qu'il y a une grande réticence aux Etats-Unis chez les étudiants en médecine à s'engager dans des spécialisations à risques telles la chirurgie générale, la cardiologie ou la gynécologie-obstétrique, à cause des tarifs d'assurances extrêmement élevés et de la pression des patients et des familles. Pareil, donc, pour les médecins qui acceptent de pratiquer l'avortement, et qui finissent par se spécialiser dans les IVG.

Avortement aux États-Unis Et en anglais, Un dossier très complet

Autres sources: http://www.guttmacher.org/pubs/fb_i...

http://www.religioustolerance.org/a...

Recrudescence des mouvements de droite dure

Sitôt après l'élection d'Obama, la droite radicale s'est manifestée bruyamment.

Cette droite radicale ne représente pas une quantité négligeable, puisqu'elle a probablement , pour faire échec à Obama, voté massivement pour McCain (qui a tout de même obtenu 40% des voix environ dans le pays, malgré tous les handicaps qu'il cumulait, dont l'héritage catastrophique, son âge, son état de santé, la bêtise crasse de sa colistière et le risque qu'elle le remplace à la tête de l'Etat)).

D'ailleurs, les lobbys des armes et anti-avortement s'étaient engagés dans une campagne féroce de dénigrement d'Obama.

Convention de la NRA (vague de nouvelles adhésions, armuriers en rupture de stock, attaques virulentes et insensées contre le nouveau président).

Le nouveau visage de la droite américaine.

La liberté d'expression

Cet article soulève également la question de la liberté d'expression telle qu'elle est conçue aux Etats-Unis.

Peut-on tout laisser faire au nom de la liberté d'expression?

Les Américains sont très attachés à la liberté d'expression telle qu'elle est garantie par le 1° Amendement de la Constitution:

C'est d'ailleurs au nom de la liberté d'expression que Noam Chomsky a rédigé un texte pour expliquer que défendre la liberté d'expression de quelqu'un n'était pas adhérer à ses idées, précisant également que signer des pétitions uniquement en faveur de ceux dont on partage les idées n'était pas défendre la liberté d'expression."Le Congrès ne fera aucune loi qui touche l'établissement ou interdise le libre exercice d'une religion, ni qui restreigne la liberté de la parole ou de la presse, ou le droit qu'a le peuple de s'assembler paisiblement et d'adresser des pétitions au gouvernement pour la réparation des torts dont il a à se plaindre".

Ce qui est imparable - mais, hélas, au-delà de l'entendement des petits philosophes à la petite semaine dont nous sommes affublés en France et qui monopolisent les médias et interdisent toute réflexion intellectuelle.

Mais je m'éloigne.

Oui, disais-je, peut-on encore parler de liberté d'expression quand il y a harcèlement, expéditions punitives, divulgation de données personnelles et crimes, voire assassinats?

Peut-on parler de liberté d'expression quand ces groupes d'extrême droite se livrent à des actes extrêmes, poussés en cela par la haine propagée même par des personnages publics et influents?

Peut-on parler de liberté d'expression quand les manifestants contre la guerre ou contre la politique gouvernementale n'ont pas le droit de protester le long du parcours des responsables politiques incriminés, ou quand leur point de vue est banni des médias dominants?

Interdire les manifestations sur son passage, c'est ce qu'a exigé Bush et ce qui se passe aujourd'hui en France où seule une claque triée sur le volet a le droit de s'approcher des élus (ou pas, d'ailleurs – ce qui devient de plus en plus courant avec la multiplication de planques ministérielles ou de postes de "conseillers" du même acabit) censés répondre de leurs actes devant le peuple.

Des bassines et du zèle 06/06

Une proposition pour repenser la « constitution » des marchés financiers

Sous des dehors parfois complexes, la régulation des marchés financiers repose sur une idée simple : il faut et il suffit que tous les investisseurs soient correctement informés pour que tout aille bien. Par « aller bien », on entend que les actifs financiers s’échangent à leur valeur fondamentale. Cette idée, qui fonde en quelque sorte la « constitution » des marchés financiers, est basée logiquement sur les deux présupposés suivants :

- il existe une vérité objective de la valeur des actifs financiers, que l’on qualifie de « valeur fondamentale ». « Vérité objective de la valeur » signifie ici une valeur parfaitement indépendante de ce que pensent et décident les investisseurs, ces derniers étant définis comme les acteurs qui prennent effectivement les décisions d’achat et de vente de titres.

- il existe un ensemble fini d’informations, que le régulateur est capable d’identifier et de délimiter, qui permet d’estimer la valeur fondamentale définie en ce sens.

Les problèmes que posent ces hypothèses découlent avant tout de la nature même de ces biens très particuliers que sont les actifs financiers : ce sont des promesses de revenus futurs. Dire qu’ils ont une valeur objective, c’est dire que le futur, en tout cas tout ce qui dans le futur aura un impact sur ces revenus, est objectif. A la suite d’André Orléan, nous considérons cette « hypothèse d’objectivité du futur » comme intenable.

A partir de là, comment refonder la régulation des marchés financiers sur des bases différentes ? Cette régulation existe avant tout pour s’assurer que ces marchés respectent une forme de bien commun. On peut repartir de l’argument le plus général que l’on donne pour justifier l’existence des marchés financiers : la négociabilité des risques. Il consiste à dire qu’en rendant liquides, donc négociables sur un marché, des biens tels que des titres de propriété, des parts d’emprunt, ou des produits dérivés sur ces biens, on réduit le risque pour les détenteurs de ces biens. Le point que nous soulignons alors est qu’en même temps que la négociabilité de ces titres est instaurée, est instaurée aussi la façon dont leurs prix sont produits, sur la base d’un mode d’interdépendance liant les investisseurs entre eux. Nous proposons, à partir de là, une dissociation entre négociabilité et valorisation.

Il peut exister en effet des biens qui soient formellement négociables mais dont le prix soit fixé par une autorité extérieure. Dans le cas des actifs financiers, on aurait le droit d’en acheter ou d’en vendre, mais à la condition de trouver une contrepartie qui accepte de conclure la transaction à ce prix fixé par cette autorité. Leur négociabilité, réductrice de risques, serait préservée ; en revanche la volatilité de leur valorisation, importante source de risque, serait fortement diminuée.

Notre proposition se fonde sur l’idée que la valeur des actifs financiers présente deux caractéristiques remarquables :

- c’est un enjeu pour la collectivité, pour la société dans son ensemble.

- il n’y a pas de vérité objective ou scientifique de cette valeur.

Les objets présentant ces deux caractéristiques sont des objets politiques. L’autorité dont nous parlons serait donc une instance politique, soit directement élue, soit désignée par des élus. En même temps sa procédure de décision inclurait l’écoute des arguments des différentes parties prenantes, le recours à une expertise ou à différentes formes d’expertise. Elle serait plus proche d’une procédure judiciaire que d’une procédure parlementaire. Il s’agit en somme de concrétiser sous une forme institutionnelle le fait que la valorisation d’un actif financier résulte d’un jugement, et que ce jugement a des conséquences pour la collectivité.

Le développement de notre idée part d’une discussion de la théorie de l’efficience informationnelle, qui constitue le fondement académique de l’ « idée simple » dont nous parlions au départ. Après une critique de cette théorie menée dans le cadre de sa propre épistémologie, nous avancerons une réflexion sur ce qui fait qu’on y a toujours recours en pratique, avant de développer un peu plus notre proposition alternative sur la régulation.

L’efficience informationnelle comme « constitution » de la finance : critique théorique, compréhension pratique, proposition d’alternative

Essai sur le fondement théorique de la régulation des marchés financiers

IntroductionLe fondement théorique principal de la régulation des marchés financiers est la théorie de l’efficience informationnelle. De façon générale il réside dans le raisonnement suivant lequel la diffusion de l’information pertinente aux investisseurs leur permet d’estimer la valeur fondamentale des actifs, et que c’est ce qui permet in fine à la valeur cotée sur les marchés de ces actifs financiers de ne pas s’éloigner durablement de cette valeur fondamentale. Cette idée se décline en particulier dans ce que nous avons appelé par ailleurs l’idéologie de la transparence (Charron, 2004) qui renvoie à la fois à l’idée que la diffusion de l’information est destinée aux investisseurs pour leur permettre d’accéder à la vérité de la valeur des actifs financiers, et que cette vérité de la valeur, cette valeur fondamentale ou intrinsèque a un caractère objectif (1).

L’efficience informationnelle est une des deux principales acceptions de l’hypothèse de marchés efficients, l’autre étant l’efficience technique que l’on peut résumer par l’idée qu’un investisseur ne peut pas « battre le marché », ne peut obtenir un rendement supérieur à celui du marché, en tout cas pas de façon durable et significative (Bourghelle, Brandouy, Orléan, 2005) (2).

L’hypothèse d’efficience informationnelle, seule, permet de fonder théoriquement la politique des régulateurs. L’efficience technique ne peut pas jouer ce rôle puisqu’elle n’établit pas de lien entre information, valeur fondamentale et évolution des cours : elle se contente de poser que cette évolution obéit à certaines caractéristiques statistiques. C’est donc la théorie de l’efficience informationnelle qui sert en quelque sorte de « constitution » aux marchés financiers (3).

Il en résulte que les crises financières sont aujourd’hui pensées par les régulateurs, mais aussi bon nombre d’économistes et de responsables gouvernementaux, comme résultant de problèmes de transmission d’informations.

Ces crises sont des périodes de remise en cause de la valorisation des actifs financiers : les actions d’Enron ou de WorldCom, les actions des start-up ou plus largement des entreprises de haute technologie, les produits dérivés issus de la titrisation de différentes formes de crédit et par ricochet les valeurs financières et immobilières ont été plus ou moins soudainement considérés comme grossièrement surévalués. Tout cela ne serait pas arrivé, pense-t-on, si l’information permettant la valorisation correcte de ces titres avait été diffusée à tous.

Cette façon d’appréhender les crises financières n’est en un sens pas nouvelle. Les présenter en expliquant que les investisseurs ont été trompés ou abusés est très classique, et cela renvoie implicitement à l’idée qu’ils n’ont pas eu la bonne information, celle qui leur aurait révélé la vérité objective de la valeur. Ce qui est plus récent, c’est la justification théorique de ce cadre interprétatif et la façon dont cette théorie est traduite et mise en œuvre par des institutions et dans des réglementations. C’est ce qui donne sa force et sa prégnance particulière à des versions formalisées et rigoureuses de cette vieille idée.

Il semble qu’après chaque crise les régulateurs et les membres de la communauté financière (gérants, brokers, analystes, investisseurs institutionnels…) font des hypothèses sur les informations qu’ils auraient dû avoir et qui, pensent-ils, auraient pu permettre de l’éviter ; les autorités de régulation édictent des recommandations et mettent en œuvre des réglementations qui découlent de ces hypothèses, jusqu’à l’arrivée d’une nouvelle crise qui amène à se reposer les mêmes questions, parfois sous des formes différentes. Il s’avère, en somme, qu’encore une fois les investisseurs n’avaient pas l’information qu’ils auraient dû avoir…

Nous examinerons d’abord la question de la validité scientifique de la théorie de l’efficience informationnelle, avant de se pencher sur le rôle que lui font jouer les acteurs qui font vivre les marchés financiers et sur ce qui peut expliquer ce rôle. Nous conclurons en essayant d’esquisser de quelle façon la régulation des marchés financiers pourrait être repensée sur la base des impasses auxquelles semble se heurter son fondement théorique traditionnel.

1. Les limites de la théorie de l’efficience informationnelle

Une différence majeure entre efficience technique et efficience informationnelle est que la première n’est qu’un modèle descriptif alors que la seconde est un modèle explicatif. La première nous dit essentiellement que l’évolution des cours est imprévisible et suit une marche au hasard, ce qui implique que tout pari directionnel est voué à l’échec ; il s’agit d’une caractérisation statistique, donc d’une description de l’évolution des cours. La seconde nous dit que l’évolution des cours reflète celle de la valeur fondamentale des titres via la prise en compte de l’information, qui permet d’estimer cette valeur fondamentale ; l’évolution de cette dernière est donc le facteur explicatif unique de l’évolution des cours. Walter (1996) a relevé chez Fama (1965, 1970) ce passage du descriptif (déjà présent chez Bachelier (1900)) à l’explicatif.

En situation d’efficience informationnelle, les cours reflètent à tout instant l’information disponible et, dans la mesure où cette propriété est vérifiée, ils sont aussi à tout instant les meilleurs estimateurs de la valeur fondamentale des titres.

Cette hypothèse a été déclinée par Fama (1970) sous trois formes différentes, suivant le type d’information qui est instantanément intégré dans le cours : dans l’efficience faible, seule l’information sur l’historique de cours est instantanément intégrée ; dans l’efficience semi-forte, toute l’information publique sur les titres est elle aussi instantanément intégrée ; enfin, dans l’efficience forte, absolument toute l’information, même privée et confidentielle, est instantanément intégrée. Une information qui n’est pas instantanément prise en compte, intégrée dans le cours, est une information dont un investisseur peut tirer parti. Elle seule permet en effet d’anticiper l’évolution de la valeur fondamentale et donc de tirer profit d’un pari directionnel puisqu’il existe dans ce cas un écart temporaire entre cours et valeur fondamentale.

Ce qui fonde la validité d’une hypothèse de ce type, c’est la possibilité de la tester de façon concluante. C’est particulièrement vrai dans le cas qui nous occupe. En effet, la position épistémologique de Milton Friedman, dans le sillage duquel se sont situés les fondateurs de la théorie de l’efficience, était de type instrumentaliste, inspirée du positivisme logique du Cercle de Vienne, ce qui implique notamment que la validité scientifique d’une théorie ne repose pas sur le réalisme de ses hypothèses mais sur sa capacité à fonder des prédictions testables. C’est ce qui fonde l’ « économie positive » friedmanienne. La discussion de la validité scientifique de la théorie de l’efficience informationnelle est donc une discussion de son mode de test.

On pourrait penser spontanément que la meilleure façon de tester l’efficience informationnelle serait de comparer directement évolution du cours et évolution de la valeur fondamentale pour un actif financier (ou une classe d’actifs financiers) donné(s). C’est ce qu’a tenté de faire en particulier Shiller (1981), qui a réalisé ce test avec trois définitions différentes de la valeur fondamentale. Il ressortait clairement de cette recherche que, dans tous les cas, la volatilité des cours était beaucoup plus marquée que celle de la valeur fondamentale, en tout cas à un degré qui semblait permettre d’invalider la théorie de l’efficience informationnelle. Une partie importante de l’évolution des cours paraissait clairement décorrélée de la valeur fondamentale.

En pratique, le test de l’efficience informationnelle ne se fait généralement pas de cette façon. On chercher plutôt à identifier des rendements anormaux. Pourquoi ?

Pour comprendre d’où vient le test sur la base des rendements normaux, il faut revenir à la façon dont l’efficience a été formalisée par Fama (1970) en s’appuyant sur des travaux de Samuelson (1965) et Mandelbrot (1966). Ces travaux ont utilisé des modèles de jeu équitable qui sont une généralisation du modèle de marche au hasard initialement développé par Bachelier (1900). Fama définit ces modèles comme suit :

« Most of the available work is based only on the assumption that the conditions of market equilibrium can (somehow) be stated in terms of expected returns. In general terms, […] such theories would posit that conditional on some relevant information set, the equilibrium expected return on a security is a function of its “risk”. And different theories would differ primarily in how “risk” is defined.” (Fama, 1970, p. 384)

Le « rendement d’équilibre espéré » obtenu sur un marché financier par un investisseur rémunère le risque qu’il prend sur ce marché. Ce risque est défini par un modèle de jeu équitable. Fama revient ensuite plus précisément dans une note sur ce qui caractérise ce type de modèle :

“the “fair game” properties of the model are implications of the assumptions that (i) the conditions of market equilibrium can be stated in terms of expected returns and (ii) the information is fully utilized by the market in forming equilibrium expected returns and thus current prices.” (Fama, 1970, p. 385)

On observe ici le type de lien entre modèle de jeu équitable et intégration de l’information : ce type de modèle pose par hypothèse que l’information est pleinement et instantanément intégrée. Par conséquent tester ce type de modèle c’est aussi tester l’intégration instantanée de l’information. Or le test d’un modèle de jeu équitable se fait en observant si des écarts se manifestent par rapport à la rémunération du risque, au « rendement d’équilibre espéré » qu’on appellera par la suite plus simplement rendement normal. La rémunération du risque équivaut par hypothèse à l’intégration complète et instantanée de l’information pertinente ; il en découle que l’observation de rendements s’écartant de cette rémunération, en d’autres termes de rendements anormaux, signifie que de l’information n’a pas été intégrée complètement et/ou instantanément.

L’évolution de la valeur fondamentale est, nous l’avons dit, le seul facteur explicatif de l’évolution du cours dans ce cadre théorique. Pour comprendre comment Fama établit le lien entre explication des mouvements de cours par des mouvements de la valeur fondamentale et intégration de l’information testée à l’aide d’une modélisation du risque, il faut revenir aux textes (Fama, 1965, 1970) pour voir plus précisément comment cette notion de valeur fondamentale y est comprise et reliée à une modélisation probabiliste.

Le fait est que l’efficience informationnelle a été pensée par Fama et ses successeurs comme assurant que le cours représente une valeur fondamentale pensée comme objective, i.e. indépendante du fonctionnement du marché et de ce que peuvent décider ou penser ses acteurs. Si l’information est intégrée (et c’est ce qu’on teste en regardant s’il y a des rendements anormaux), alors le cours reflète la vérité de la valeur, une valeur fondamentale objective. Mais alors c’est ce fait qu’il faut expliquer : pourquoi a-t-on besoin de poser dans ce cadre ce qu’Orléan (2005) a justement appelé l’ « hypothèse d’objectivité de la valeur » ?

Il nous semble que la réponse est liée au passage du descriptif à l’explicatif dont nous avons déjà parlé : les mouvements de cours ayant été décrits par Bachelier (1900) sur le mode d’un phénomène objectif relevant des sciences de la nature et Fama reprenant à son compte ce mode de description, ils ne pouvaient à partir de là être expliqués que par un facteur posé comme tout aussi objectif et « naturel » (4). L’objectivité dont il est question ici est avant tout extériorité totale par rapport aux acteurs : les acteurs sont face à ce phénomène, qui leur est extérieur, ils n’en sont pas partie prenante. C’est parce que Fama a repris à son compte la compréhension, initiée et formalisée par Bachelier, des mouvements de cours de Bourse comme totalement extérieurs aux acteurs qu’il ne pouvait penser un facteur explicatif de ce mouvement que comme tout aussi extérieur aux acteurs : la valeur fondamentale ne peut qu’être objective parce que ce qu’elle explique et qui la reflète est objectif.

L’idée générale exprimée par Bachelier dès 1900 est que les marchés « ne pensent rien », ne sont ni haussiers ni baissiers : il n’y a pas de tendance, les mouvements de cours s’effectuent de façon aléatoire et leur étude relève donc de l’étude du hasard telle qu’elle a été développée et formalisée par les approches probabilistes. C’est l’hypothèse de marche au hasard.

Bachelier part du fait que la fixation du cours pour une transaction sur un marché boursier confronte acheteurs (logiquement haussiers) et vendeurs (logiquement baissiers), et en déduit que le marché en tant que tel n’est ni haussier ni baissier : « pour chaque cours coté, il y a autant d’acheteurs que de vendeurs ». « le marché ne croit, à un instant donné, ni à la hausse, ni à la baisse du cours vrai. » On en déduit que « l’espérance mathématique du spéculateur est nulle. » Bachelier précise : « Si le marché, en effet, ne prévoit pas les mouvements, il les considère comme étant plus ou moins probables, et cette probabilité peut s’évaluer mathématiquement. » (Bachelier, 1900, cité par Walter, 1996, p. 877) (5).

Fama, dans son article de 1965, s’est notamment attaché à montrer que cette approche de la « marche au hasard » était compatible avec l’idée que les cours reflètent la valeur fondamentale des titres.

Le problème qu’il se pose est le suivant : si les déplacements de prix successifs sont indépendants, que peut-on dire sur ce qui détermine ces déplacements ? A cette réponse il ne voit que deux réponses possibles : soit les investisseurs se déterminent au hasard, suivant leur caprice (« whim »), soit ils sont concentrés sur l’estimation de la valeur fondamentale des actifs financiers. Le passage vaut d’être cité en entier :

« Independence of successive price changes for a given security may simply reflect a price mechanism which is totally unrelated to real-world economic and political events. That is, stock prices may be just the accumulation of many bits of randomly generated noise, where by noise in this case we mean psychological and other factors peculiar to different individuals which determine the types of “bets” they are willing to place on different companies. Even random walk theorists, however, would find such a view of the market un-appealing. Although some people may be primarily motivated by whim, there are many individuals and institutions that seem to base their actions in the market on an evaluation (usually extremely painstaking) of economic and political circumstances. That is, there are many private investors and institutions who believe (6) that individual securities have “intrinsic values” which depend on economic and political factors that affect individual companies.” (p. 36)

L’existence de la valeur fondamentale (« intrinsic value ») des titres est ici présentée comme une croyance dont on constate l’existence chez “beaucoup” d’investisseurs et d’institutions. Or, dès la phrase suivante, la valeur fondamentale cesse d’être une croyance observée pour devenir un fait dont l’existence est indiscutable : le problème qui se pose dans la relation entre théorie de la marche au hasard et valeur fondamentale, c’est qu’il faut montrer que la théorie de la marche au hasard est compatible avec l’existence indiscutée de la valeur fondamentale :

“The existence of intrinsic values for individual securities is not inconsistent with the random-walk hypothesis. In order to justify this statement, however, it will be necessary now to discuss more fully the process of price determination in an intrinsic-value-random-walk-market. Assume that at any point in time there exists, at least implicitly, an intrinsic value for each security.” (p. 36)

Nous pouvons ensuite constater que le travail de caractérisation statistique qui consiste dans cet article à tester l’hypothèse de marche au hasard revient à regarder à quelle type de loi obéit la série des déplacements de prix, en considérant en somme cette série exactement comme un phénomène dont l’objectivité est du type de celle qui est censée caractériser les sciences de la nature (variation de température, de pression etc.) (7).

Or on ne voit pas comment un phénomène objectif de ce type pourrait être expliqué par une croyance ou plus généralement par un facteur socialement construit : si le déplacement des cours, statistiquement caractérisé comme une marche au hasard, est considéré comme un phénomène naturel, il ne peut être déterminé que par un facteur tout aussi naturel et objectif que, par exemple, la pression atmosphérique ou la température extérieure.

Il est donc nécessaire, dans la logique de ce raisonnement, que, si le déplacement des cours est déterminé par un facteur quelconque, il faut que ce facteur existe « dans la nature », i.e. de façon totalement indépendante des acteurs et du fonctionnement du marché, antérieurement à l’échange (ex ante). Il faut que la valeur fondamentale de l’actif financier existe aussi sûrement que la température extérieure : le seul problème est de trouver un thermomètre qui fonctionne correctement. C’est parce que le naturel ne s’explique pas par le social que la valeur fondamentale ne peut être qu’un fait objectif et non une croyance observée.

Fama développe ensuite (p. 36 à 39) un raisonnement qui consiste à montrer que les deux propositions suivantes :

(1) les prix des titres suivent une marche au hasard

(2) les prix des titres reflètent à tout instant leur valeur fondamentale

sont compatibles, ce qui est contre-intuitif : on pourrait en effet penser, spontanément, que si les cours suivent leur valeur fondamentale, ils ne se déplacent pas au hasard. C’est de cette compatibilité (« consistent with ») que parle l’auteur lorsqu’à la fin de l’article il introduit la notion d’efficience. En d’autres termes il s’agit de montrer que l’explication (par la valeur fondamentale) est compatible avec la description (marche au hasard).

Le raisonnement est fondé essentiellement sur le rôle de l’arbitrage (8) : l’idée est qu’il existe sur le marché des intervenants plus avisés que d’autres (il parle à plusieurs reprises d’ « astute traders ») qui sont dotés d’une capacité particulière à estimer la valeur fondamentale des titres.

On peut résumer le raisonnement de Fama sur le lien entre cours et valeur fondamentale en trois propositions :

(1) la valeur fondamentale d’un actif financier existe ex ante.

(2) au moins une partie des intervenants sur le marché est capable de l’estimer.

(3) ces intervenants utilisent cette connaissance de la façon suivante : quand ils voient que le cours d’un titre s’écarte de sa valeur fondamentale, ils anticipent son retour à cette valeur et prennent des positions sur le marché en fonction de cette anticipation, ce qui ramène effectivement le cours à sa valeur fondamentale.

La proposition (3) présuppose la proposition (2), qui elle-même présuppose la proposition (1).

Reste que Fama, dans cet article, n’a fait que démontrer la compatibilité de la marche au hasard et de la détermination par la valeur fondamentale. L’article de 1970 ira plus loin en se fondant sur les modèles de jeu équitable (Samuelson, 1965 ; Mandelbrot, 1966) qui sont en fait des généralisations du modèle de marche au hasard sous la forme de modélisations du risque permettant de déterminer un rendement normal, notion servant dès lors de base aux tests d’efficience, comme nous l’avons vu. Ces modèles posent toujours l’intégration des informations, censée expliquer les variations de cours, comme un phénomène aléatoire : « si l’information arrive de manière imprévisible sur le marché, alors il est possible de modéliser les variations des prix actualisés des actifs financiers (la « valeur actuelle » des financiers) comme les résultats de tirages aléatoires indépendants : les prix actualisés des actifs suivent des martingales. » (Walter, 1996)

Fama pose, nous l’avons vu, que ces modèles supposent l’efficience informationnelle, pensée comme assurant que le cours reflète la valeur fondamentale : il n’est plus question de compatibilité mais d’implication. L’important pour lui est de disposer dès lors d’un modèle à la fois explicatif et testable, dans la logique de l’ « économie positive » friedmanienne.

Récapitulons : la valeur fondamentale d’un actif financier est comprise comme objective parce qu’elle est le facteur explicatif d’un phénomène (l’évolution des cours) qui est compris comme objectif via une modélisation du risque. Sur cette base s’est imposé un mode de test qui consiste non pas à comparer directement évolution du cours et évolution de la valeur fondamentale, comme l’a fait Shiller, mais à vérifier si l’évolution du cours obéit bien à une modélisation du risque dont on suppose qu’elle correspond à l’intégration de l’information permettant d’estimer la valeur fondamentale.

Ce mode de test de l’efficience informationnelle pose, nous semble-t-il, au moins deux problèmes.

Le premier avait été perçu dès l’origine par Fama, dans son article de 1970. C’est ce qu’il a appelé par la suite le problème de l’hypothèse jointe : ce qui est testé n’est pas directement l’efficience informationnelle, donc l’intégration complète et instantanée de l’information pertinente dans le cours, mais, de façon jointe, l’efficience informationnelle et un modèle d’évaluation du risque, la rémunération du risque traduite par un rendement normal équivalant par hypothèse à une situation d’efficience informationnelle.

Fama exprime le problème sous cette forme :

“we should note right off that, simple as it is, the assumption that the conditions of market equilibrium can be stated in terms of expected returns elevates the purely mathematical concept of expected value to a status not necessarily implied by the general notion of market efficiency. The expected value is just one of many possible summary measures of a distribution of returns, and market efficiency per se (i.e., the general notion that prices “fully reflect” available information) does not imbue it with any special importance. Thus, the results of tests based on this assumption depend to some extent on its validity as well as on the efficiency of the market. But some such assumption is the unavoidable price one must pay to give the theory of efficient markets empirical content.” (Fama, 1970, p. 384)

En d’autres termes, le modèle de risque utilisé (pour Fama et la plupart de ses successeurs ce fut le MEDAF) n’est pas le seul possible, mais la part d’arbitraire qui consiste à en choisir un parmi d’autres est le prix à payer pour que la théorie des marchés efficients soit testable.

Le deuxième problème est l’absence de définition, de délimitation a priori de l’information pertinente. Que peut-on dire du rapport entre la pertinence de l’information et le mode de test que nous avons décrit ? Concrètement, pour le mettre en œuvre, on regarde si, au voisinage de la date de divulgation d’une information donnée, on observe des rendements anormaux. Et alors, sous réserve qu’on ait correctement contrôlé les autres facteurs, de deux choses l’une :

-soit il n’y a pas de rendements anormaux, en tout cas pas à un degré significatif. Cela veut dire que l’information en question est intégrée dans le cours.

-soit il y a des rendements anormaux. Cela signifie que cette information n’est pas intégrée dans le cours. La théorie des marchés efficients nous explique alors que cette non-intégration est nécessairement provisoire : des investisseurs avisés vont repérer l’inefficience et, en en tirant parti par des paris directionnels, vont la résorber.

Le point sur lequel nous pouvons attirer l’attention est le fait que, dans les deux cas, on suppose que l’information que l’on teste est pertinente. En effet, si elle ne l’est pas, en d’autres termes s’il n’y a pas de raison pour qu’elle ait un impact sur la valeur fondamentale, alors on ne peut pas tirer de conclusion de ce que l’on observe. Que l’on constate ou non l’existence de rendements anormaux au voisinage de la date de divulgation de l’information, il n’y aura de toute façon aucune raison pour que cela soit en rapport avec cette information, et on ne pourra donc rien inférer.

Cela signifie qu’on ne peut rien dire, en toute rigueur, sur la relation entre information et cours si l’on ne définit pas a priori l’information pertinente. Il faut donc, a priori, disposer d’un ou plusieurs critère(s) permettant de distinguer ex ante dans l’ensemble de l’information disponible celle qui est pertinente de celle qui ne l’est pas.

Or la seule définition de l’information pertinente que l’on peut tirer des textes fondateurs de la théorie est que c’est l’information qui contribue à l’estimation de la valeur fondamentale. En d’autres termes, quand on cherche une définition de l’information pertinente, on est renvoyé à la définition de la valeur fondamentale.

Il existe bien sûr plusieurs définitions de la valeur fondamentale d’un actif financier, mais elles peuvent se résumer de la façon suivante : il s’agit de la somme actualisée des flux de revenus futurs générés par cet actif. Estimer la valeur fondamentale repose donc à la fois sur une anticipation (de flux de revenus futurs) et sur le choix d’un taux d’actualisation. Poser cette notion comme objective, comme c’est le cas dans le cadre de la théorie de l’efficience informationnelle, c’est par conséquent poser (au moins) ce qu’André Orléan a appelé « l’hypothèse d’objectivité du futur » (Orléan, 2006) (9). Nous suivrons cet auteur pour considérer cette hypothèse comme logiquement intenable : l’estimation de la valeur fondamentale d’un actif financier est irréductiblement subjective, notamment parce que deux acteurs également rationnels et disposant des mêmes informations peuvent parfaitement retenir des scénarios différents pour le futur et donner deux estimations dont aucune ne peut être considérée comme plus objective, rationnelle ou informée que l’autre. Nous citerons aussi ici l’un des arguments qu’il avance : l’objectivité du futur « is incompatible with the free will of agents as modelled by this very same economic theory. If we believe in individual free will, then the future must be considered to be undetermined and contingent: it is the product of individual decisions, including those taken in the sphere of finance.” (Orléan, 2006, p.8) Elle est aussi incompatible, plus spécifiquement, avec l’idée que les marchés financiers jouent un rôle actif en termes d’allocation des ressources à l’économie. “Clearly, there is a fundamental logical contradiction in assuming simultaneously that the markets reflect a pre existing reality and that their presence is capable of improving, and therefore transforming, the functioning of the economy.” (ibid., p. 8). L’idée d’une valeur fondamentale objective déterminant l’évolution des cours des actifs financiers implique en fait que cette évolution n’a aucun impact sur l’économie dite « réelle » (résultats et dividendes des sociétés cotées, taux de défaut sur les remboursements d’emprunts etc.), qu’elle n’en est que le simple reflet. Il n’est pas besoin d’avoir vécu ou de vivre des situations de crise financière pour considérer cette idée comme intenable.

La valeur fondamentale d’un actif financier n’existe pas ex ante, et il en découle qu’il est impossible de délimiter a priori l’information permettant de l’estimer, donc l’information pertinente, celle sur laquelle doit être testée l’efficience informationnelle.

En résumé, le mode de test de l’efficience informationnelle souffre d’une part irréductible d’arbitraire dans le choix de la modélisation du risque permettant de réaliser le test et d’une impossibilité de séparer a priori l’information pertinente de celle qui ne l’est pas.

L’invalidation du mode de test entraîne, dans son propre cadre épistémologique, celle de la théorie. Il n’en demeure pas moins que cela ne suffit pas, selon nous, à disqualifier cette théorie en tant que fondement de la régulation des marchés financiers. Il convient en effet de distinguer la question de la validité scientifique d’une théorie de celle du rôle qu’elle peut jouer pour fonder logiquement, justifier et légitimer en pratique des règles et des institutions. Si la discussion de la théorie de l’efficience informationnelle n’avait d’enjeu qu’académique, nous pourrions ne pas aller plus loin. Or il est clair que tel n’est pas le cas. Simplement, si l’on veut aborder la question du rôle que joue cette théorie dans le fonctionnement réel des marchés financiers, il faut s’interroger en particulier sur les besoins qu’elle satisfait dans ce cadre ; c’est ce que nous allons maintenant tenter de faire.

2. Pratiques de la théorie financière et modes d’interdépendance

La dépendance envers une modélisation du risque particulière et discutable (10) et l’impossibilité de délimiter clairement a priori l’information pertinente remettent en cause le mode de test de la théorie de l’efficience informationnelle et in fine la théorie elle-même. Il n’en demeure pas moins que, concrètement, les investisseurs sont contraints, le plus souvent, d’utiliser une modélisation du risque et, toujours, de sélectionner dans l’ensemble d’informations dont ils disposent celles qu’ils vont effectivement utiliser pour décider. L’utilisation de modélisations du risque ressort de l’approche distributionnelle des marchés financiers, i.e. de la perception de l’évolution des cours comme relevant d’une forme de hasard probabilisable, qui s’est imposée très majoritairement au cours des dernières décennies chez les investisseurs professionnels, reléguant à la marge l’approche directionnelle qui caractérise en particulier l’analyse technique et qui consiste à percevoir l’évolution des cours comme une succession de mouvements haussiers et baissiers, différents outils et indicateurs permettant de repérer ces tendances et d’essayer d’anticiper les changements de tendance. En pratique il reste possible pour un investisseur de ne pas recourir à une modélisation du risque ; en revanche il est impossible de ne pas sélectionner l’information, particulièrement en un temps où au développement des agences de presse spécialisées (Reuters, Bloomberg), acquis dès les années 80, s’est ajouté le développement d’Internet et les capacités accrues de diffusion rapide d’informations de toute sorte (provenant d’agences, de médias généralistes, de médias spécialisés, mais aussi plus récemment de forums, de blogs etc.) (11). Souligner les insuffisances du cadre théorique qui fonde la régulation des marchés financiers et constitue un des piliers, voire le principal pilier de la théorie financière ne suffit donc pas lorsque cela laisse ouvertes des questions que les investisseurs sont obligés de trancher pour pouvoir travailler.

La théorie financière, en particulier la « théorie moderne du portefeuille » et la théorie de l’efficience, a accompagné le développement de la finance et en a largement structuré les pratiques professionnelles (Bernstein (2000), Rainelli (2003), Mackenzie (2006)). Une critique ne peut fonder une alternative pratique au rôle que joue ce cadre théorique que si elle répond aux besoins des acteurs de la communauté financière, faute de quoi elle est d’avance condamnée à rester dans le champ clos des controverses académiques.

Nous allons donc nous demander à quels besoins de ces acteurs répondent les outils tirés de la théorie financière. Nous le ferons précisément en considérant les investisseurs comme des acteurs et en comprenant leur rôle comme une façon de s’inscrire dans des modes d’interdépendance. Cette approche relève des sciences sociales et plus précisément de la sociologie dans l’acception qu’en donnait Norbert Elias. Dans « Qu’est-ce que la sociologie ? » (Elias, 1993), ce dernier fonde sa définition de la discipline sur une représentation de la société comme un ensemble de modes d’interdépendance ou de configurations, représentation qui se substitue à une perception de la société comme réalité extérieure à l’individu (p. 9-10).

Nous poserons que les investisseurs sont pris dans deux modes d’interdépendance :